სულ რაღაც რამდენიმე ათწლეულში ხელოვნურმა ინტელექტმა ფართო გავრცელება ჰპოვა ყოველდღიურ ცხოვრებაში. მანქანური სწავლება გამოიყენება ერთმანეთისგან განსხვავებულ სფეროებში, ტექსტებისა და სურათების გენერირებიდან დაწყებული ამინდის პროგნოზირებამდე, მანქანების მართვამდე და რენტგენის სხივებში პათოლოგიების გამოვლენამდე. თუმცა, ჩვენი ტვინისაგან განსხვავებით, მისი მსგავსებით შექმნილი AI არ არის უცვლელი - ნეირონული ქსელები მუდმივად ვითარდება კონკრეტული პრობლემების გადასაჭრელად.

ნეირონული ქსელის ტექნოლოგია თავდაპირველად გამოჩნდა როგორც ბიოლოგიური ნერვული ქსელების სტრუქტურის ანალოგი. ქსელში ნეირონები წარმოდგენილია კვანძებით, რომელიც ამუშავებენ მონაცემებს და ცვლიან ერთმანეთთან. ნეირონებს შორის კომუნიკაცია ხდება სინაფსების საშუალებით, რომლებიც აძლიერებენ ან ასუსტებენ სიგნალს. ქსელი სწავლობს, მაგალითად, უფრო ძლიერი კავშირების განვითარებით კვანძებს შორის ერთდროულად მაღალი მნიშვნელობებით. სინაფსების პარამეტრებისა და გამომავალი ნეირონების მახასიათებლების მიხედვით, შეგიძლიათ მიიღოთ ისეთივე შედეგები როგორიც ადამიანის ტვინის შემთხვევაში. თუ ალგორითმს აქვს ნერვული ქსელის სტრუქტურა, მას შეუძლია მონაცემების ანალიზი, შედეგის დამახსოვრება და სხვადასხვა ექსპერიმენტის შედეგების პროგნოზირება.

არსებობს ნეირონული ქსელები სხვადასხვა კლასიფიკაცია, მაგალითად სტრუქტურის მიხედვით: ერთშრიანი და მრავალშრიანი, პირდაპირი გავრცელების და განმეორებითი, ან რადიალური ბაზისის მქონე. არსებობს ასევე კლასიფიკაცია სწავლის ტიპის მიხედვით: ზედამხედველობით ან უკონტროლო, ანალოგური, ორობითი ან ფიგურალური, ფიქსირებული ან დინამიური კავშირებით. თუმცა შეუძლებელია ყველა არსებული ტიპის ნეირონული ქსელის ჩამოთვლა, რადგან მუდმივად იქმნება ახალი ალგორითმები. თითქმის ყველა ნეირონული ქსელი შედგება რამდენიმე ფენისგან, რომლებზედაც განთავსებულია კვანძები, ან ხელოვნური ნეირონები - მათემატიკური ფუნქციები მრავალი შემავალი და გამომავალი პარამეტრით, რომლებიც გადადის ფენიდან ფენაში, ქსელის ტოპოლოგიიდან გამომდინარე.

არის სფეროები, სადაც უკვე შეუძლებელია ნერვული ქსელების გარეშე. ყველა ამოცანა, რომლითაც მუშაობს ნერვული ქსელები, შეიძლება დაიყოს რამდენიმე ტიპად:

- რეგრესია - ამოცანები რიცხვებით, იქნება ეს ადამიანის ასაკი თუ გაცვლითი კურსის პროგნოზი;

- კლასიფიკაცია - გამოსახულების, სახეების, ობიექტების, ნიმუშების ამოცნობა და ა.შ.;

- პროგნოზირება - მომავლის პარამეტრების პროგნოზირება;

- კლასტერირება - მონაცემების დახარისხება, სეგმენტირება და გაერთიანება მახასიათებლების მიხედვით;

- გენერაცია - სურათების, ტექსტების, ბგერების შექმნა ან ტრანსფორმაცია.

ცოცხალი ორგანიზმების ნერვული უჯრედების ორგანიზებისა და ფუნქციონირების პრინციპზე აგებული მათემატიკური მოდელის საწყისად შეიძლება ჩაითვალოს ამერიკელმა მეცნიერების Warren McCulloch-ის და Walter Pitts-ის 1943 წელს გამოქვეყნებული ნაშრომი „ნერვულ აქტივობასთან დაკავშირებული იდეების ლოგიკური გაანგარიშება“, სადაც შემოთავაზებულია იდეა, რომ ადამიანის ტვინში ნეირონები მოქმედებენ ბინარულ რიცხვებზე, ისევე როგორც კომპიუტერები. შემდგომში, ნერვული ქსელების შესწავლა განვითარდა ორი მიმართულებით: ზოგიერთმა მეცნიერმა შეისწავლა ბიოლოგიური პროცესები, რომლებიც ხდება ადამიანის ტვინში, ზოგმა კი დაიწყო ნეირონული ქსელების შექმნა, როგორც ხელოვნური ინტელექტის ნაწილი.

ხელოვნური ინტელექტის განვითარების მიმართულებით ძირითადი მიღწევებია:

- 1950 წელს ჟურნალ Mind-ში გამოჩნდა Alan Turing-ის სტატია "გამოთვლითი მანქანები და გონება", სადაც შემოთავაზებული ტესტის იდეა, რომელიც საბოლოოდ განსაზღვრავს, შეუძლია თუ არა მანქანას აზროვნება.

- 1958 წელს Frank Rosenblatt-მა დაასრულა მუშაობა ‘პერცეპტრონზე’ - მოწყობილობაზე რომელიც არსებითად ერთი ნეირონი მოდელი იყო (თანამედროვე ნერვული ქსელები შედგება მილიონობით ნეირონისგან).

- 1970-იანი და 1980-იანი წლების მიჯნაზე მეცნიერებმა გააცნობიერეს, რომ პერცეპტრონები შეიძლება გაერთიანდეს დიდ ქსელებში და მოხდეს მისი სწავლება როგორც ერთიანი ორგანიზმის. თუმცა, ეს იდეა იმ დროს მხოლოდ თეორიულად არსებობდა.

მიუხედავად პრაქტიკული განხორციელების შეუძლებლობისა, 1980-იან წლებში გამოიგონეს ახალი ალგორითმები, გამოსახულების კლასიფიკაციისთვის და ტექსტის ანალიზისა და მანქანური თარგმნისთვის. იმდროინდელი ჟურნალები წერდნენ, რომ რობოტები აპირებდნენ შეცვალონ ადამიანები, სტარტაპები ჰპირდებოდნენ ბიზნესს უპრეცედენტო მოგებას, მაგრამ ნერვული ქსელები მაინც ითვლებოდა მხოლოდ თეორიულ იდეად. მე-20 საუკუნის ბოლოსთვის განვითარდა კომპიუტერები და მეცნიერთა სურვილები საბოლოოდ განხორციელდა.

ცალმხრივი ნეირონული ქსელის სტრუქტურა ასე შეგვიძლია წარმოვიდგინოთ. თითოეული ნეირონის გამომავალი სიგნალია რიცხვი - უმარტივეს შემთხვევაში ეს არის ან 0 (ნეირონს სძინავს და არ აგზავნის სიგნალს) ან 1 (ნეირონი აქტიურია). ეს რიცხვი დამოკიდებულია სხვა ნეირონებიდან შემომავალი სიგნალების შეწონილ ჯამზე და ნეირონი აქტიურდება თუ ეს ჯამი აღემატება გარკვეულ სიდიდეს, წინააღმდეგ შემთხვევაში ნეირონს სძინავს.

ნეირონებს შორის თითოეულ კავშირს ყოველ ჯამში ენიჭება წონა, რაც უფრო დიდია მისი აბსოლუტური მნიშვნელობა, მით უფრო ძლიერია გამგზავნი ნეირონის აგზნების სიგნალი, რომელიც გავლენას ახდენს მიმღები ნეირონის აგზნებაზე. წონა და აქტივაციის ზღურბლები თავდაპირველად არ არის დაფიქსირებული - ეს არის ნეირონული ქსელის სასწავლო პარამეტრები. მოდელის სწავლება მოიცავს ოპტიმალური მნიშვნელობების არჩევას მოცემული ამოცანის კონტექსტში.

მარტივ მოდელში პერცეპტრონების ქსელში შემავალი სიგნალი ვრცელდება თანმიმდევრულად, ფენა-ფენა. შესაძლებელია კავშირების სხვა ტიპებიც, მაგალითად, როდესაც ნეირონებს შეუძლიათ მიიღონ ინფორმაცია არა მხოლოდ მეზობლებისგან, არამედ უფრო შორეული კვანძებიდანაც.

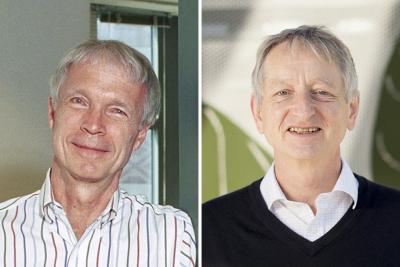

2024 წლის ნობელის პრემიის ლაურეატები ფიზიკაში 1980-იანი წლებიდან ახორციელებდნენ მნიშვნელოვან კვლევებს ნეირონული ქსელების ტექნოლოგიის განვითარებისთვის ფიზიკური პრინციპების გამოყენებით.

John J. Hopfield-მა (პრინსტონის უნივერსიტეტი, აშშ), რომელიც ამჟამად 91 წლისაა, შექმნა ასოციაციური მეხსიერება, რომელსაც შეუძლია სურათების და სხვა ტიპის შაბლონების შენახვა და მოძიება მონაცემებში. Hopfield-ის ქსელს ქონდა პერცეპტრონების ცალმხრივი ნეირონული ქსელის სტრუქტურა, მაგრამ მნიშვნელოვანი განსხვავებით. მის მოდელში არ იყო კონკრეტული მიმართულება - ყველა ნეირონი ურთიერთქმედებდა ყველა დანარჩენთან. საწყისი მდგომარეობად არჩეული იყო შემავალი სიგნალი, ხოლო გამოსავალზე მოდელი იძლეოდა ნეირონების კოლექტიური სიგნალს. ამიტომ, ასეთი სქემის სწავლებისადმი მიდგომა ოდნავ განსხვავებული უნდა ყოფილიყო.

მეცნიერს ასეთი სქემის განხორციელებაში დაეხმარა სტატისტიკური ფიზიკის მოდელი, რომელიც აღწერს ფერომაგნიტების ქცევას. ფერომაგნიტებს ადამიანის ტვინისა მსგავსად გააჩნიათ მეხსიერების ეფექტი - სპინები ლაგდებიან გარე მაგნიტური ველის გავლენის მიმართულებით, თუმცა ინარჩუნებენ დამაგნიტებას გარეგანი გავლენის გაქრობის შემდეგაც, თითქოს ახსოვთ ის ველი, რომელმაც მათი დამაგნიტება გამოიწვია.

Hopfield-ის მიერ გამოყენებულ ფერომაგნიტურ მოდელში, რომელიმე შერჩეული ღერძის გასწვრივ თითოეულ ატომს ენიჭება ორი მდგომარეობიდან ერთი: მაგნიტური მომენტის მიმართულებით (+1) ან (-1). ამავდროულად, თითოეული ცალკეული მაგნიტური მომენტი გრძნობს სხვა მომენტების ჯამურ მაგნიტურ ველს და შეიძლება შეიცვალოს ორიენტაცია, ან შეინარჩუნოს საწყისი მდგომარეობა.

ასეთი სისტემისთვის თითოეული ატომის სხვა ატომებთან ურთიერთქმედების ენერგია ტოლია მაგნიტური მომენტისა და ველის მნიშვნელობის ნამრავლის ნახევრის. მაგნიტური მომენტების სისტემის დინამიკა ისეთია, რომ მომენტების ორიენტაციის ცვლილებისას ენერგია არ იზრდება - ანუ ნებისმიერი საწყისი მდგომარეობა კოლექტიური ურთიერთქმედების გავლენის ქვეშ სპონტანურად მიისწრაფვის ენერგიის უახლოესი ლოკალური მინიმუმისკენ.

ურთიერთქმედი მაგნიტური მომენტების მოდელი ბევრად უფრო ბუნებრივი აღმოჩნდა, ვიდრე ცალმხრივი ნეირონული ქსელი. მეხსიერების ეფექტი აქ აღარ საჭიროებს ნეირონების განსაკუთრებულ გეომეტრიულ განლაგებას და საჭირო შაბლონები ბუნებრივად წარმოიქმნება მრავალი ნეირონის კოლექტიური ურთიერთქმედების შედეგად. თითოეული ნეირონი დაკავშირებულია ყველა დანარჩენთან, როგორც ფერომაგნიტებში. მომენტის მიმართულება განისაზღვრება გამომავალი სიგნალით, მაგნიტური ველი არის შემავალი სიგნალების შეწონილი ჯამი, ხოლო მაგნიტური მომენტების რეორიენტაცია გადადის ნერვული სიგნალების აქტივაცია/გამორთვაში.

ასეთი ანალოგიის მთავარი სარგებელი ის არის, რომ ნეირონების ნებისმიერი საწყისი კონფიგურაცია მიისწრაფის უახლოესი სტაბილურისკენ. ნეირონები თითქოს ლაგდებიან მეხსიერებიდან ცნობილ შაბლონში, ყველაზე ახლოს თავდაპირველთან - ისევე, როგორც ადამიანის მეხსიერებას შეუძლია ცნობილი ინფორმაციის რეპროდუცირება შემოთავაზებული მიახლოებითი მონაცემებიდან. სისტემის სტაბილური კონფიგურაციები ცალსახად განისაზღვრება ქსელის წონებით: წონების სწორი მნიშვნელობების არჩევით შესაძლებელია ერთ ან მეტ ნეირონულ კონფიგურაციაზე ლოკალური ენერგიის მინიმუმის შექმნა და ამით საჭირო სურათების ჩასმა ქსელის მეხსიერებაში. როდესაც ქსელს ეძლევა დამახინჯებული, ან არასრული სურათი, ის მეთოდურად გადის კვანძებში და განაახლებს მათ მნიშვნელობებს ისე, რომ ქსელის ენერგია შემცირდეს. ასე რომ, ქსელი მუშაობს ეტაპობრივად, რათა იპოვნოს შენახული სურათი, რომელიც ყველაზე მეტად ჰგავს იმ სურათს, რომელიც მას მიეწოდა.

მეორე ლაურიატი Geoffrey Hinton (ტორონტოს უნივერსიტეტი, კანადა) ამჟამად 76 წლისაა. მან გამოიგონა მეთოდი, რომელსაც შეუძლია დამოუკიდებლად იპოვოთ თვისებები მონაცემებში და ამით შეასრულოს ისეთი ამოცანები, როგორიცაა სურათებში გარკვეული ელემენტების იდენტიფიცირება.

Hinton-მა გამოიყენა Hopfield-ის ქსელი, როგორც საფუძველი ახალი ქსელისთვის, რომელიც მრავალი ერთნაირი კომპონენტისგან შემდგარი სისტემების აღსაწერად იყენებს სტატისტიკური ფიზიკის მეთოდებს, ე. წ. ბოლცმანის მანქანას. დეტერმინისტული გადასვლის ნაცვლად დაბალი ენერგიის მდგომარეობაზე, შემოთავაზებული იქნა გადაადგილება მდგომარეობათა სივრცეში სტოქასტური ტრაექტორიების გასწვრივ. არ იყო აუცილებელი ენერგია შემცირებულიყო ევოლუციის ყოველ საფეხურზე, არამედ გადასვლების ალბათობა ექვემდებარებოდა ბოლცმანის განაწილებას, ხელსაყრელია გადასვლა უფრო დაბალი ენერგიის მქონე მდგომარეობებზე, ხოლო მაღალი ენერგიების მქონე მდგომარეობები ექსპონენციალურად არიან დათრგუნული ენერგიისა და ტემპერატურის პარამეტრის თანაფარდობით. ეს ქცევა დამახასიათებელია წონასწორული თერმოდინამიკური სისტემებისთვის და ასევე შეიძლება გამოყენებულ იქნას სასრულ ტემპერატურაზე მაგნიტური მომენტების სისტემის ქცევის აღსაწერად. იმის გამო, რომ სისტემის მდგომარეობის ცვლილებები ალბათურია და არას დეტერმინირებული, ქსელმა შეიძინა ახალი სასარგებლო თვისება: ლოკალური ენერგეტიკული მინიმუმების შერჩევა. ბოლცმანის მანქანა არ იჭედებოდა უახლოეს სტაციონალურ მდგომარეობაში და აკეთებდა სიგნალების კონფიგურაციის ანალიზს. რაც უფრო დაბალია სიგნალის ენერგია, მით უფრო სავარაუდოა, რომ ის გამოჩნდებოდა ნეირონულ ქსელში და პირიქით.

სტოქასტური ბუნების გამო, მოდელმა დაკარგა ფრაგმენტებიდან ჩაწერილი სურათების საიმედოდ „დამახსოვრების“ უნარი, მაგრამ სანაცვლოდ მან მიიღო ახალი შესაძლებლობა: სწავლების დროს ქსელს შეუძლია დაიმახსოვროს ტრენინგის სტატისტიკური განაწილება თვით საგნების ნაცვლად და დამოუკიდებლად შექმნას ახალი, ადრე უცნობი მდგომარეობები განაწილებიდან. ქსელი სწავლობს სავარაუდო მაგალითებთან შედარების მეშვეობით.

ბოლცმანის მანქანა შეიძლება გამოყენებულ იქნას სურათების კლასიფიკაციისთვის ან ახალი შაბლონების შესაქმნელად უკვე ნაცნობი მაგალითების გამოყენებით, ასევე რთული კომბინატორიული პრობლემების გადასაჭრელად. Hinton-ის შრომამ საფუძველი ჩაუყარა მანქანური სწავლების ტექნოლოგიების ამჟამინდელ სწრაფ განვითარებას.

ნობელის პრემიის გადაცემის ოფიციალური ცერემონია სტოკჰოლმში 10 დეკემბერს, ალფრედ ნობელის გარდაცვალების დღეს გაიმართება. პრიზის ოდენობა 2024 წელს 11 მილიონი შვედური კრონა, ანუ დაახლოებით 1,06 მილიონი დოლარი იქნება. ფულადი ჯილდოს გარდა, შვედეთის მეფე ლაურეატებს მედლებსა და დიპლომებსაც გადასცემს.

წყარო:

https://www.nobelprize.org/prizes/physics/2024/press-release/